写在前面

请配合原文食用

因为太菜,论文我没看懂,就翻译了一遍。水平糟糕,如果有错误,请指出。(?)表示 我也不知道有没有翻译对= =

胸部X线疾病筛查的外部缺陷数据深度挖掘

- I. 介绍(Introduction)

- II. 相关工作(RELATED WORKS)

- III. 方法(METHODOLOGY)

- *III-A 部分标签分类的基础框架(Basic Framework for Partial-label Classification)*

- *III-B. 公共知识挖掘的特定任务对抗训练(Task-specific Adversarial Training for Common Knowledge Mining)*

- *III-C. 利用不确定感知时间整合挖掘隐藏知识(Uncertainty-aware Temporal Ensembling for Hidden Knowledge Mining)*

- *III-D. 网络结构与训练方案(Network Architecture and Training Scheme)*

- IV. 实验与结果(EXPERIMENTS AND RESULTS)

- V. 讨论(DISCUSSION)

- VI. 总结(CONCLUSION)

简介——深度学习在自动胸部X射线分析中展现出卓越的成果。深度模型的数据驱动特征需要训练数据来覆盖巨大的分布。因此,从众多数据集中整合知识,特别是医学图像,是大量需要的。然而,使用额外的胸部X射线(CXR)数据学习疾病分类模型还具有挑战性。最近的研究表明,数据模型性能的瓶颈在 对不同CXR训练集的联合训练上,只有很少一部分人去尝试着解决这个问题。在本文中,我们认为,包含外部CXR数据集导致了训练数据的缺陷,这就对我们提出了挑战。具体来说,这种缺陷的数据有两个方面的表现:域差异(domain discrepancy),因为数据集之间的图像外观变化;标签差异(label discrepancy),因为不同数据集是部分被标记的。为此,我们根据类别将 多标签胸部疾病分类问题 制定为 加权独立二分类任务。 对于那些跨域共享的公共类别,我们采用(adopt)任务特定对抗训练(task-specific adversarial training)来缓和特征差异。对于在单一数据集中存在的类别,我们提供了模型预测的不确定性感知时间集合?(temporal ensembling),进一步从丢失标签中挖掘信息。 这样,我们的框架同时地模型(models)和解决(tackles)了域和标签差异(的问题),开启了高级知识挖掘能力。我们在3个数据集(超过36万张CXR图片)上开展了广泛的实验。我们的方法优于其他竞争模型,并在官方NIH测试中奠定了最先进的性能(state-of-the-art),具有0.8349的精确度。这说明了他利用外部数据集来提高内部分类(效果)的效率。

I. 介绍(Introduction)

??胸部X射线(CXR)是世界上最常用的医学影像技术,在许多胸部疾病的诊断中起到了十分关键的作用,比如说肺炎、肺膨胀不全、肺结节等。CXR快速、简单的特点,导致了每天大量的临床检查。然而,人工去阅读这些X射线(照片)是需要专业知识的、消耗时间的、容易出错的。所以,疾病的自动检测在帮助射线照片的诊断上,有巨大的价值。

??到目前为止,数百上千个大规模数据集已经被发布了[1],[2],[3],[4]。可以获得的公共的CXR图片的数量已经增加到将近100多万。该数据规模的提升 为数据驱动的 胸部疾病自动诊断方法铺平了道路,比如说深度学习(DL)。如今,许多基于深度学习的研究[5],[6],[7],[8]已经在不同的CXR数据集上开展。这些工作致力于如何使得一个神经网络能够更好的匹配单一数据集。在另一方面,深度学习的数据驱动特征需要训练数据涵盖巨大的(特征)分布。因此,深度模型在涵盖额外数据集之后效果往往会更好。然而,在多种多样的CXR上联合训练(joint training)仍然是具有挑战性的。先前的研究已经指出,当使用来自外部数据集的CXR图像时,性能的提高是有限的[9],[10],[11]。比如说,Yao等人[9]开发了一个二分类深度学习模型,通过5个CXR数据集上的联合训练,识别健康病例的病理图像。然而,(他们的结果表明)在增加大约50万的训练数据过后,AUROC在NIH测试集[2]上的得分仍然未变。

??我们认为阻碍是产生于 包含了外部数据集之后所带来的缺陷数据。由Tajbakhsh等人[12]提出,深度学习需要大量,有代表性的,高质量被标注的数据。然而,要求医学影像在同一标准(环境)下被收集,是不切实际的。相反,不同数据集是通过不一样的采样(sampling)、成像(imaging)和标记(labeling)标准而获得的。因此(Therefore),采用外部CXR数据集在两个方面上面临着缺陷数据(imperfect data)。第一,来自不同数据集的CXR图像具有(possess)域差异(domain discrepancy)。这是由 影响图像特征分布的因素 产生的,比如说不同的影像协议(imaging protocols),不一致的数据预处理过程(inconsistent pre-processing approaches),多种扫描视图(multiple scanning view)等。然而,数据驱动的方法高度依赖 训练数据恰好的符合测试集的特征分布。涵盖 脱离了最初特征分布的(外部的)额外数据 不能给内部数据集带来(训练效果的)提升。第二,不同的CXR数据集使用了不同的数据标记策略,这就导致了标签差异(label discrepancy)。具体来说,不同的数据集专注于不同的病理学特征(pathological findings)。比如说,NIH数据集分了14类疾病,CheXpert数据集[3]分了13类,二者只有7种类别是共同的。接着,当处理多个CXR数据集时,X射线图像的部分标记是因为每张图像中有些疾病是未知的。图1展示了图像外观和分类分布在NIH和CheXpert数据集上的对比(comparison)。

图1 来自NIH和CHEXPERT的图像与标签分布的比较。注意到CheXpert数据集不仅在像素级别上与NIH数据集不同,而且包含有更多(方向)的视图(CheXpert大约35%的图片都是侧视图)。右:NIH和CheXpert训练数据集的标签分布直方图。CheXpert数据集拥有更多常见的病理分类,还有其他的健康病例。这两个数据集共20个分类分别是Emphysema (Emph), Fibrosis (Fibr), Hernia (Hern), Infiltration (Infi), Pleural Thickening (PT), Mass, Nodule (Nodu), Atelectasis (Atel), Cardiomegaly (Card), Consolidation (Cons), Edema (Edem), Effusion (Effu), Pneumonia (Pne1), Pneumothorax (Pne2), Enlarged Cardiomediastinum (EC), Fracture (Frac), Pleural Other (PO), Lung Opacity (LO), Lung Lesion (LL), and Support Devices (SD). 每个类别的特定数量可以在表I中找到。

??重要的是,刚提到的两个差异彼此地增加了难度。对于那些部分被标记的数据,对于某些类别,具有未知标签的图像可视为未标记数据。然而,如果要从未标记数据中学习的话,就要求图像采样于同一(特征)分布的标签集。有研究指出[10],[13],直接把一个CNN从一个CXR域中应用到另一个CXR域上,会发生严重的性能衰减。在另一方面,标签差异(label discrepancy)也对 学习域不变特征 提出了挑战。由于标签分布的差异性较大,学习到的区分语义(discriminative semantics)很容易区分不同领域的特征,网络无法获得更好的跨域转移性[14]。

??为了解决这些问题(challenges),我们提出通过同时克服图像和标签差异来学习外部数据集。因为内部和外部数据集之间的标签空间不同,**我们将 胸科疾病筛查的多标签分类目标 设定为每个类别的加权独立二分类任务。**为了解决域差异,我们提出了一种针对特定任务的对抗训练策略。特别地,对于每个公共类别,我们采用了一个特定的域鉴别器(domain discriminator)来区分每个域的特征。同时,网络(模型)被要求去学习更多 可以迷惑域鉴别器的的域不变特征(domain-invariant features)。因此(hence),网络能够更有效地挖掘公共类别中的知识。此外,为了从未知分类中挖掘更多的隐藏知识,我们将 模型预测的时间整合(temporal ensembling of the model’s prediction) 作为未知类别的软目标。由于加入的外部域会引起更高概率的分布外预测(out-of-distribution predictions),我们利用(leverage)不确定性机制(uncertainty mechanism)来防止模型的积累误差(accumulating errors)。这一阶段,我们的深度神经网络可以同时model和解决(address)域差异和标签差异。我们在3个CXR数据集,包含超过36万张来自NIH、CheXpert和私有数据集ImsightCXR的图片,上进行了广泛的实验。我们的方法取得了一致的提升(consistent improvements),并优于其他(竞争)方法,在NIH数据集上以0.8349的AUC取得了最先进的(state-of-the-art)性能。这项工作的贡献总结如下:

- 我们提出了一个新颖的多标签CXR疾病筛查框架,它可以从外部数据中学习到额外的知识。

- 我们提出了一个针对特定任务的对抗学习方案来缓解(不同)CXR数据集的域差异,并使得深度模型可以更有效地(more effectively)学习到共同知识(common knowledge)。

- 我们设计了一个高效的不确定性感知时间整合机制,来解决标签差异,并使得深度模型可以从未知标签(的数据)中学习到隐藏知识。

- 我们在3个数据集上,在不同的实验条件下,进行了广泛的实验,展现我们提出的方法的效果。通过挖掘外部数据的知识,我们的方法在官方NIH测试数据集上取得了最世界领先的(state-of-the-art)效果。

II. 相关工作(RELATED WORKS)

II-A 胸部X射线疾病筛查(Chest X-ray Disease Screening)

??自动胸部X射线疾病筛查有非常悠久的历史,它可以追溯到1963年,Lodwick等人 人为地设计了许多 描述符(descriptors)来检测肺癌[15]。直到最近几年,研究人员才开始利用数据驱动的方法,比如说深度学习,对大规模数据集进行多标签分类[2],[3]。Wang等人[2]发布了包含112,120张射线照片的NIN CheX-ray14数据集,并使用各种不同的卷积神经网络(CNN)在上面进行了一系列的基准研究(benchmark studies)。基于这个如此大的数据集,Yao等人[16]把长短期记忆(long-short-term-memory)[17]应用于卷积神经网络(CNN)来研究(exploit)疾病之间的依赖关系。Wang等人[18]进一步提出一个文本图像嵌入网络(text-image embedding network),利用自由文本(free-text)放射性的扫描报告(reportscan)作为前置知识来分类(classify)和解释(interpret)CXR。Tang等人[19]采用了基于弱监督疾病定位的课程学习策略(curriculum learning strategy)。为了进一步利用损伤部位的信息,Li等人[20]提出使用受限的边界框监督(limited bounding-box supervision)来改善基于多实例学习(multiple instance learning)的分类性能。对我们来说,最有价值的是Yao等人[9]和Guendel等人[21]的工作。前者(Yao等人)搭建了一个深度神经网络 从正常射线照片(normal radiographs)中识别 病理学特征(pathological findings),在5个数据集上训练,并10个数据集上测试。后者(Guendel等人)在NIH数据集和PLCO数据集上进行了联合训练(joint training),并且利用PLCO数据集[1]上的空间知识(spatial knowledge) 来改善在 NIH数据集上的效果。然而,二者的工作的结果表明,对于AUC得分的增长有限。

II-B从外部缺陷数据集中学习(Learning from Imperfect External Dataset)

??缺陷数据(imperfect data)[12]可能是由 未标记的数据(unlabeled data)或者是 部分标记的数据(partially-labeled data)引起的。最近的研究表明,基于时间整合(temporal-ensemble-based)的方法可以通过正则化未标记数据的预测结果(by regularizing the predictions on unlabeled data) 来改善模型(benefit model)[22],[23],[24]。Yu等人[25],[26],[27]进一步提出,不确定性驱动(uncertainty-driven)策略 能够引导(guided)模型学习到更具鲁棒性(robust)和稳定性(stable)的知识。对于部分标记的数据(partially-labeled data),Zhou等人[28]研究了 使用部分标记域(partially-labeled domains) 的 多器官分割(multi-organ segmentation),并 提出了 先前感知(prior-aware)神经网络。为了解决多标签分类中的标签缺失(missing labels)问题,Yang等人[29]提出,利用语义图(semantic graph)Laplacian作为多标签学习中的光滑项,将结构化语义关联(structured sematic correlations)结合起来。Wu等人[30]搭建了一个依赖关系图(dependency graph) 把已有标签(given labels)的 (标签)信息 传播(propagate)给 丢失标签(missing labels)(的数据)。Durand等人[31]提出 课程驱动(curriculum-driven)的深度卷积神经网络 用于 学习预测未知标签(的数据)。然而,以上所提到的所有工作 都假定,所有数据集都采样于 同一分布,并且没有考虑 域对齐(domain alignment)。

??为了解决数据集当中的域差异(domain discrepancy)(问题),Rebuffi等人[32]提出,学习 跨视觉域(across visual domain)的通用数据表示法(universal data representations) 的思想。Liu等人[33]进一步将 通用学习(universal learning) 扩展到 医学图像分割(领域)。Van等人[34]把不同形式(modality)结合在一起,用于丰富训练数据。然而,这些方法常常都是基于 充分标记的数据(fully labeled data),但是 数据集中的标签差异(label discrepancy)仍然无人涉足(unexplored)。

??处理 医学图像分析域差异的 另一个高度相关的领域 是 域适应(domain adaptation)。例如,Wang等人[35],[36] 利用 语义感知(sematic-aware)生成对抗网络(generative adversarial nets),它能够 鼓励(encouraged)生成 域不变(domain-invariant)的分割掩膜预测(segmentation mask prediction),并能够把 从一个2D数据集中学到的知识 迁移到另一个 具有域差异的 2D数据集上。Zhang等人[37],[38]提出,无监督 交叉形式(cross-modality)域适应框架,将一种模式上训练的卷积网络适应于另一种模式,用于三维医学图像分割。这些工作通常是为了使 模型从有标记的源域 适应到 未标记的目标域,但是其结果的效率通常低于 有标记目标域上训练的模型。

III. 方法(METHODOLOGY)

??图2举例说明了我们方法的学习框架。在下一节中,我们首先介绍缺陷数据(imperfect data)分类问题的 符号(notations)和我们的加权部分标签(weighted partial-label)公式。然后,我们提出了针对特定任务的对抗训练(task-specific adversarial training)损失(公式),以缓解 特征级域差异(feature level domain difference),并在公共类别中挖掘公共知识(common knowledge)。最后,我们介绍 使用 不确定性感知(uncertainty-aware) 时间整合(temporal ensembling)(方法)来从 未知类别 中 挖掘 隐藏知识。

图2 (我们)提出框架的总览。模型的输入 是 来自两个不同数据集的图像,他们有着 不同的外观和不一致的标签空间。特征产生器(Feature Generator) 学习 每个二分类任务的特征 并输出对应分类的得分。框架的基本目标(basic objective)是 分类损失(classification loss)。对于每个公共类别,都有一个 域鉴别器(domain discriminator)根据域(according to domain)来区分(separate)特征。鉴别器根据 特定任务的对抗损失 训练。对于那些只存在于内部的分类(internal-only categories),模型预测结果的 不确定性驱动的 时间整合(the uncertainty-driven temporal ensembling)被用作 丢失标签(missing labels)(数据)的软目标(soft targets)。

III-A 部分标签分类的基础框架(Basic Framework for Partial-label Classification)

??令 X d = { ( I d 1 , y d 1 ) , … , ( I d n , y d n ) } X^d=\{(I^{d_1},y^{d_1} ),…,(I^{d_n},y^{d_n})\} Xd={(Id1?,yd1?),…,(Idn?,ydn?)}为我们所提出方法中涉及的 d t h d^{th} dth数据集。 I d i I^{d_i} Idi?为来自数据集 X d X^d Xd的 i t h i^{th} ithCXR图片。 y d i = [ y 1 d i , … , y C d i ] ∈ Y d ? { 0 , 1 } C y^{d_i}=[y_1^{d_i},…,y_C^{d_i}]∈Y^d?\{0,1\}^C ydi?=[y1di??,…,yCdi??]∈Yd?{0,1}C是标签向量。对于给定的来自数据集 X d X^d Xd的样本 i i i和分类 c c c, y C d i = 1 y_C^{d_i}=1 yCdi??=1(其他的还有0,-2)表示该类为真(假,未知)。进一步, l d l^d ld表示数据集 X d X^d Xd的全标签的目标空间(fully labeled target space), ? l ?l ?l表示标签目标空间的交集。

??自动CXR图像筛查可以被当作多标签分类。也就是说,一个从 给定图片

I

I

I?到 标签向量

y

∈

R

C

y∈\Bbb{R}^C

y∈RC??的映射函数。我们将目标描述为一组C加权独立的二分类任务,如下所示:

L

c

l

s

=

?

1

C

∑

c

=

1

C

α

c

[

β

c

?

1

[

y

c

=

1

]

log

?

(

p

c

)

+

1

[

y

c

=

0

]

log

?

(

1

?

p

c

)

]

\mathcal{L}_{cls} = -{1 \over C} \sum_{c=1}^C \alpha_c[\beta_c \cdot \Bbb{1}_{[y_c=1]}\log(p_c) + \Bbb{1}_{[y_c=0]} \log(1-p_c)]

Lcls?=?C1?c=1∑C?αc?[βc??1[yc?=1]?log(pc?)+1[yc?=0]?log(1?pc?)]

??其中,

L

c

l

s

\mathcal{L}_{cls}

Lcls?表示部分标签分类损失(partial-label classification loss),

p

∈

R

C

p∈\Bbb{R}^C

p∈RC为神经网络的预测结果向量,

1

[

?

]

\Bbb{1}_{[?]}

1[?]?表示指示函数(indicator function),

α

\alpha

α和

β

\beta

β是权重参数(weighting parameters)。特别地,

β

c

=

N

c

P

c

β_c= {N_c \over P_c}

βc?=Pc?Nc??,其中,

N

c

N_c

Nc?为类别

c

c

c负样本的总数量(标签为0),

P

c

P_c

Pc?为类别

c

c

c正样本的总数量(标签为1)。另外,受到论文[39]的启发,我们发现独立二分类任务仍然有不一样的困难。因此,部分任务可能主导着训练过程中的整体梯度(overall gradient)。为此,我们为每个二分类任务都分配了不同的权重α_c来平衡不同任务的梯度。具体来说,任务的权重是根据 是否这个分类任务跨域共享(is shared across domain)所制定的。因此,当**更多权重被赋予给公共任务(common tasks)之后,AUC(准确率)的提升是很明显的。**这些都会在之后的实验中展示出来。

III-B. 公共知识挖掘的特定任务对抗训练(Task-specific Adversarial Training for Common Knowledge Mining)

??就上文提及的,CXR数据集之间存在严中的域偏差(domain bias),使得联合训练的效果受限或衰减。为了解决这个问题,我们提出通过对抗训练来缓解特征级别域差异(feature-level domain discrepancy)。令多标签分类神经网络为

F

(

G

(

I

)

)

F(G(I))

F(G(I)),其中

G

G

G为特征生成器(feature generator),

F

F

F是特征分类器(feature classifier),也就是(i.e.),全连接层(FC-layer)。对抗训练可以应用在域分类器

D

D

D(domain discriminator)和特征生成器

G

G

G?(feature generator)最小化最大值的竞争中:

L

a

d

v

(

G

,

D

,

I

)

=

E

G

(

I

d

)

~

X

d

[

log

?

D

(

G

(

I

d

)

)

]

??

E

G

(

I

?

d

)

~

X

?

d

[

log

?

(

1

?

D

)

G

(

I

?

d

)

]

\mathcal{L}_{adv}(G,D,I) = \Bbb{E}_{\mathcal{G}(I^d)\sim X^d}[\log\mathcal{D}(\mathcal{G}(I^d))]~~\Bbb{E}_{\mathcal{G}(I^{-d}) \sim X^{-d}}[\log(1-\mathcal{D})\mathcal{G}(I^{-d})]

Ladv?(G,D,I)=EG(Id)~Xd?[logD(G(Id))]??EG(I?d)~X?d?[log(1?D)G(I?d)]

原文中 log ? D ( G ( I d ) \log\mathcal{D}(\mathcal{G}(I^d) logD(G(Id)?? 处少个一个 “)”

其中, L a d v L_{adv} Ladv???为对抗训练损失, G ( I d ) \mathcal{G}(I^d) G(Id)??是从域d中学习到的特征, G ( I ? d ) \mathcal{G}(I^{-d}) G(I?d)??是其他域的特征。特征生成器G的目标是最小化目标,以对抗试图最大化目标的对手 D D D??。因此,上面所提及的目标是 min ? G max ? D L a d v ( G , D ) \min_\mathcal{G}\max_\mathcal{D}\mathcal{L}_{adv}(\mathcal{G},\mathcal{D}) minG?maxD?Ladv?(G,D)?? 。这样,特征生成器能够学习到如何生成 更具有域不变性(domain-invariant)的特征。

??一般地,

G

G

G以全局平均池化层(global average pooling layer)结束,

f

=

G

(

I

)

∈

R

N

f=\mathcal{G}(I)∈\Bbb{R}^N

f=G(I)∈RN为

N

N

N维的特征向量。全连接层(FC-layer)执行矩阵乘法使得

f

\mathcal{f}

f映射为一个维度为

C

C

C的预测结果向量。我们注意到这样的设计会使得,在多标签的场景下会产生丰富的语义,可能存在

2

C

2^C

2C种组合。因此,标签分布的差异(label distributions difference)可以作为区分特征来源的依据。为了解决这个问题,我们将C个

N

×

N

′

N×N'

N×N′的平行FC层的添加到G上。新生成器G’生成的特征的维度是

N

′

×

C

N'×C

N′×C的,在这个过程中,

f

c

=

G

′

(

I

)

c

f_c=\mathcal{G}' (I)_c

fc?=G′(I)c?捕获第c类的语义。相应地,我们将

F

\mathcal{F}

F 改为

C

C

C个维度为

N

′

×

1

N'×1

N′×1的分类器,将单一的鉴别器

D

D

D?改为 每个公共类别指定的多个鉴别器。这样,我们将最小最大化竞争(mini-max game) 扩展为 多个指定类别的 子竞争(sub-games),如下:

L

t

a

t

(

G

′

,

D

′

,

I

′

)

=

∑

c

∈

∩

l

C

E

G

′

(

I

d

)

c

~

X

d

[

log

?

D

c

(

G

′

(

I

d

)

c

)

]

+

E

G

′

(

I

?

d

)

c

~

X

?

d

[

log

?

(

1

?

D

c

(

G

′

(

I

?

d

)

c

)

)

]

\mathcal{L}_{tat}(\mathcal{G}',\mathcal{D}',I') = \sum_{c\in \cap l}^C \Bbb{E}_{\mathcal{G}'(I^d)_c \sim X^d} [\log \mathcal{D}_c(\mathcal{G}'(I^d)_c)] + \Bbb{E}_{\mathcal{G}'(I^{-d})_c \sim X^{-d}} [\log(1 - \mathcal{D}_c(\mathcal{G}'(I^{-d})_c))]

Ltat?(G′,D′,I′)=c∈∩l∑C?EG′(Id)c?~Xd?[logDc?(G′(Id)c?)]+EG′(I?d)c?~X?d?[log(1?Dc?(G′(I?d)c?))]

其中,

D

′

=

{

D

c

∣

c

∈

?

l

}

\mathcal{D}'=\{\mathcal{D}_c |c∈?l\}

D′={Dc?∣c∈?l}?。因此,目标就为

min

?

G

′

max

?

D

′

L

t

a

t

(

G

′

,

D

′

)

\min_{\mathcal{G}'} \max_{\mathcal{D}' }\mathcal{L}_{tat}(\mathcal{G}',\mathcal{D}')

minG′?maxD′?Ltat?(G′,D′)??。注意,我们特意将对抗训练应用到交集类上,也就是说,

c

∈

∩

l

c\in \cap l

c∈∩l??。因此,挖掘公共类别的公共知识变得容易,指定特征更具有域不变性(domain-invariant)。上文我们提及过,我们将多标签分类改为多个独立二分类任务,上述目标称为特定任务对抗性训练(Task-specific Adversarial Training, TAT)损失。

III-C. 利用不确定感知时间整合挖掘隐藏知识(Uncertainty-aware Temporal Ensembling for Hidden Knowledge Mining)

??在上文中的框架中可以看到,CXR数据集存在由部分标签(partial labels)引起的标签差异(label discrepancy),比如说,Nodule仅在内部域中被标记,外部类却没有。对于这样缺失标签(missing labels)的类别,通过给未标记(unlabeled data)的数据 赋予伪标签(pseudo-labels),未标记的数据(unlabeled data)可以提供潜在的信息[31]。然而,在我们的例子中,外部和内部数据集存在域差异。因此,硬标记(hard labeling)(给标签值为0或1)因此也更容易积累预测误差[40]。另外,加入硬标记(hard labeling)会改变正负样本之间的比率,这就导致加权分类损失最佳化的改变。

??为此,我们提出,使用软标签(soft labels)作为未知分类(unknown categories)的目标(target)。从最近的半监督学习(semi-supervision)[22]中受到启发,我们根据 模型预测结果的指数移动平均数(exponential moving average (EMA))为伪标签赋值(assign pseudo-labels)。令神经网络迭代次数为

t

t

t时的预测结果为

p

t

p_t

pt?,时间整合的更新如下:

Z

t

=

γ

Z

t

?

1

+

(

1

?

γ

)

p

t

?

1

??

a

n

d

??

z

t

=

Z

t

1

?

γ

t

?

1

Z_t = \gamma Z_{t-1} + (1-\gamma)p_{t-1} ~~ and ~~ z_t = {Z_t \over 1-\gamma^{t-1}}

Zt?=γZt?1?+(1?γ)pt?1???and??zt?=1?γt?1Zt??

L

t

e

m

=

1

[

y

c

=

?

2

]

∥

p

t

?

z

t

∥

2

2

\mathcal{L}_{tem} = \Bbb{1}_{[y_c=-2]} \lVert p_t - z_t \rVert_2^2

Ltem?=1[yc?=?2]?∥pt??zt?∥22?

其中,

Z

t

Z_t

Zt???是预测结果的EMA,

γ

\gamma

γ??是动量项(momentum term),控制整体(ensemble)进入训练历史的程度(how far),

1

?

γ

t

1-\gamma^t

1?γt??是误差修正项,与之前的研究[22],[41]一致,

z

t

∈

[

0

,

1

]

z_t\in[0,1]

zt?∈[0,1]??是正则化的最终软目标(final soft target),

L

t

e

m

\mathcal{L}_{tem}

Ltem???是受时间整合监督(supervised by the temporal ensemble)的损失。注意到第一个世代时,也就是说,

t

=

1

t=1

t=1??,

Z

1

Z_1

Z1???被置为零。为了计算时间整合的的损失(loss with the temporal ensemble),我们使用了平方

L

2

\mathcal{L}_2

L2??? 范数。不同于交叉熵(cross entropy loss),它的结果是有界的,并且对错误的预测更不敏感[40]。并且,由于EMA的计算,使得 之后的世代对 预测结果贡献更多,这就让时间整合更稳定与可信。

??使用了我们提出的 基于时间整合的标记策略(temporal-ensembling-based labeling strategy)之后,伪标签比硬标签更不容易积累误差。然而,就像之前说的,我们的内部和外部数据集有着不一样的域分布(domain distribution),而半监督学习(semi-supervised)高度依赖 标记的数据 与 未标记的数据 采样于同一分布。对于仅存在内部的分类,来自外部数据集的分布外的图像 将导致相当多的不确定预测。就同[42]中所指出的那样,对于不确定的标签(uncertain labels),深度模型 会给予更大的分类损失。因为交叉熵损失的大小取决于预测值与0.5的接近程度,我们提出过滤掉那些不确定性预测(uncertain prediction),如下:

L

u

t

e

=

1

[

y

c

=

?

2

,

∣

0.5

?

p

t

∣

1

≥

H

]

∥

p

t

?

z

t

∥

2

2

\mathcal{L}_{ute} = \Bbb{1}_{[y_c=-2,|0.5-p_t|_1 \geq H] \lVert p_t - z_t \rVert_2^2}

Lute?=1[yc?=?2,∣0.5?pt?∣1?≥H]∥pt??zt?∥22??

其中,

∣

0.5

?

p

t

∣

|0.5-p_t |

∣0.5?pt?∣为预测不确定的估计值,

H

H

H为逐渐减少的阈值(threshold)。在迭代刚开始时,

H

H

H非常大,只有具有高确定性(high certainty)的预测结果 才能被选为软标签目标(soft label objective)。因此,我们就能够首次稳定未知分类预测的结果。当模型收敛并稳定之后,

H

H

H减小,更多的预测结果能够包含到计算之中。使用我们的不确定性感知时间整合(uncertainty-aware temporal ensemble (UTE))损失(loss),模型能够一步步地从缺失标签的数据中学习到更加可信(reliable)的知识。

??注意到,UTE与基于一致性的方法(consistency-based methods)不同,UTE在训练过程中不需要大量的数据增强策略(consistency-based methods require many data augmentation strategies during training)。我们主要利用了(take advantage of)稳定的、具有鲁棒性的、由时间整合方案生成的 平滑标签(smooth labels)。不确定性机制进一步使得模型逐步从自信样本(confident samples)中学习。因此,我们方法甚至不需要大量的数据增强,表现也很好,这点将会在下文中的IV-D1段中提及。

III-D. 网络结构与训练方案(Network Architecture and Training Scheme)

??我们将DenseIBN-121作为我们的主干网络[43]。DenseIBN-121采用了密集地跳过连接(densely skip connections)就与DensNet-121一样[44]。不同的是,DenseIBN-121在Dense Block上与Batch Normalization一起使用了Instance Normalization[45]。正如[46]原文中所示,在跨域的环境下能够具有更好的泛化性。我们修改了分类层,使它成为C个分支,每个分支都有两个全连接层,就同段III-B描述的那样。对于其他层,我们使用在ImageNet上的预训练模型(pre-trained)对其初始化[47]。鉴别器(discriminator)简单地使用3个全连接层与2个LeakyReLU层。总体的目标函数如下:

L

=

L

c

l

s

+

λ

t

a

t

L

t

a

t

+

λ

u

t

e

L

u

t

e

\mathcal{L} = \mathcal{L}_{cls} + \lambda_{tat}\mathcal{L}_{tat} + \lambda_{ute}\mathcal{L}_{ute}

L=Lcls?+λtat?Ltat?+λute?Lute?

其中,

λ

t

a

t

\lambda_{tat}

λtat???与

λ

u

t

e

\lambda_{ute}

λute????分别是对抗训练损失与无监督训练损失权重。

??在训练过程中,我们将CXR图片加载为大小 320 × 320 320×320 320×320作为输入。接着[5],我们仅仅使用水平翻转(horizontal flipping)作为数据增强的方法。我们使用Adam作为DenseIBN结构的优化器[41],RMSprop作为鉴别器的优化器[49]。Adam的初始学习率设置为 1 e ? 4 1e-4 1e?4,并在3和6个epoch之后衰减为 1 e ? 5 1e-5 1e?5和 1 e ? 6 1e-6 1e?6。RMSprop的学习率固定为 1 e ? 4 1e-4 1e?4。基于我们的预备性实验(preliminary experiments),在每次迭代过程中,对抗损失与其他损失一起训练。整个(实验的)框架由PyTorch实现[50],并在一个Titan XP GPU上进行。我们对模型进行8个epochs的训练,直到收敛。在超参数中,对于公共类令 α c ∈ ∩ l = 3 α_{c\in \cap l}=3 αc∈∩l?=3,对于其他类令 α c ∈ l d ? ∩ l = 1 α_{c\in l^d \setminus \cap l}=1 αc∈ld?∩l?=1。对于 特定任务的对抗训练 与 不确定性感知的时间整合,我们令 λ t a t = 0.03 \lambda_{tat}=0.03 λtat?=0.03, λ u t e = 30 \lambda_{ute}=30 λute?=30, γ = 0.9 \gamma=0.9 γ=0.9。

IV. 实验与结果(EXPERIMENTS AND RESULTS)

??这个部分,我们首次介绍我们实验中用到的三个数据集,与我们采用的评估指标。然后,我们在NIH数据集上展示我们的实验结果,其中使用CheXpert作为外部数据。之后,我们展示在我们自己的数据集ImsightCXR上的结果,并使用NIH作为外部数据。在最后一个小节中,描述了我们方法中 不同部件的对照实验。

IV-A. 数据集(dataset)

??我们在3个数据集上进行了实验,其中包括NIH、CheXpert和 从多个中国医院中收集的私有数据集ImsightCXR。NIH数据集 有112,120张来自32,717个病人的正视图CXR照片,每张照片都有14个可能的病理学标签(有 或 无)。CheXpert数据集 包含224,316张来自65,240个病人的正视图与侧视图CXR照片。对于在这两个公开数据集上做的实验,数据集的划分方法采用官方指定的分割法。因此,在训练集中一共有303,646张图片,其中有80,232张图片来自NIH数据集,223,414张图片来自CheXpert数据集。我们把NIH数据集中的6,292张图片用作校验,25,596张图片用作测试。在CheXpert数据集上使用U-Ones策略[3]。ImsightCXR数据集中有32,261张来自27,253个病人的正视图CXR图片。具体来说,**ImsightCXR数据集的每张图片都由三位放射科医生(radiologists)根据相应的放射学报告(corresponding radiological reports) 标记。**因此,ImsightCXR数据集的标记 比其他两个由自然语言处理标记的数据集 更加清晰。表I中展示了每个数据集阳性病例(种类的)具体数量。我们将ImsightCXR数据集拆分为训练集、校验集和测试集(没有患者的重叠),分别为13,963, 5,118和13,180张图片。

??值得注意的是,标签为“No Finding”的数据,并不意味着目标(病人)在病理学上是健康的。例如,在CheXpert数据集中将“Emphysema”, “Hernia”,“Thickening”定义为“No Finding”,就如labeler tool中所提及的那样。此外,“Mass”和“Nodule”是“Lung Lesion”的子类,“Infiltration”是“Lung Opacity”的子类。在CheXpert中,也把“Fibrosis”当作“Pleural Other”的子类。因此,我们可以说,未知分类 被标记策略(labeling strategy)所忽略了,而不是必然的不存在。

IV-B.评估标准(Evaluation Metrics)

??遵循之前的研究[2],[18],我们采用AUC(the area under the receiver operating characteristic curve)来评估我们的方法,并与其他方法比较。我们评估了每种疾病的AUC以及所有类别的平均AUC。为了验证我我们独特设计的效果,我们也计算了公共类(common categories)的平均AUC以及仅存在内部数据集的类(internal-dataset-only class)的平均AUC。除非在以下部分中指定,否则我们只能推断一次未增强的图像,并在验证和测试阶段使用单个输出(?)。我们每3600个steps验证一次模型,并选择验证中AUC(validation AUC)最高的一个进行后续评估。

NIH,CheXpert与ImsightCXR数据集中的病理学特征。对于CheXpert,我们展示了其阳性与未知标签的总和。

在NIH,CheXpert,ImsightCXR数据集中,公共6类跨段(cross-sectional)测试的AUC结果。

IV-C. 数据集差异的分析(Analysis of Datasets Discrepancy)

??除了在表I中清楚展示的标签差异外,我们在表II中展示了,三个数据集中,使用上述提及的数据集分割方式,六个公共类别的横截面测试(cross-sectional testing)。可以看到,直接将基于单一训练集训练的模型应用于另一个训练集,会导致严重的性能下降。这表明测试集的分布(distribution)与训练集的分布有很大的不同。特别地,在内部数据集上 测试(testing)使用外部数据集训练的模型(CheXpert to NIH and NIH to ImsightCXR),会导致在公共类别上至少11点的衰减。这里的实验验证了这三个数据集的域差异(domain discrepancies)。

IV-D. NIH数据集上的分类结果

??1)NIH,并使用CheXpert作为外部数据集: 我们首先将,NIH作为内部数据集,另一个巨大的数据集作为外部数据集,来展示我们方法的知识挖掘能力(knowledge mining capability)。我们在表III中展示了多种其他方法的比较,以及我们方法的一些变体:a)仅在NIH上训练的深度神经网络(Single Dataset);b)一个基础的部分标签分类网络(basic partial-label classification network),融合了NIH和CheXpert的标签(Joint Training);c)使用CheXpert作为外部域的多任务网络,并将来自两个域的相同标签视为以下[21]两个独立类别;d)a location-aware Dense Network(DNetLoc)[21],使用额外的来自PLCO数据集[1]的297,541个胸部X光照;e)深度模型的联合训练(JT-100[11]),使用全部NIH数据集以及来自MIMIC-CXR数据集[4]的额外180,000张图片。a、b和c的实验的神经网络骨架基于DenseIBN-121。d、e实验的神经网络骨架基于Dense-121。

在NIH数据集上的分类结果,以CheXpert作为外部数据集。

在NIH数据集上,与世界领先水平(网络模型)的比较。

图3 联合训练的DenseIBN-121和我们的方法的,前8个预测结果和相应的预测得分。基准真标签(ground truth labels)以红色高亮显示。图像顶部的数字是其相应的文件名。最好看彩色(Best viewed in color?)。

??我们可以从表III中看到,4/5的 使用包含外部域的方法 的性能 超过了 使用单一数据集的方法。基于多任务的模型(DNetLoc and Multi-Task)的AUC 低于 联合训练的方法(Joint Training and JT-100)。这意味着,两个数据集之间共享的信息可能没有被充分的利用,当把来自不同域的相同标签 分到 不同类上。同时,两个联合训练的基础模型的AUC达到了大约0.8200,这表明 融合来自多个域的类 有利于模型(性能的提高),并且可以帮助 挖掘 跨数据集共享的公共知识。然而,简单的融合分类、联合训练模型对外部域的利用是不够的,因为域差异(domain discrepancy)和标签差异(label discrepancy)没有得到解决。与其他方法相比,我们的方法取得了最好的性能表现,大幅度提高1.2 AUC(with a large margin with 1.2 AUC gain)。这表明,解决数据集的差异问题,有利于更有效地(more effectively)挖掘公共知识和隐藏知识。我们在图3中展示了联合训练模型的经典分类结果(typical classification results),以及我们的方法的定性比较。

??2)在NIH数据集上,与世界最领先水平的比较: 我们进一步比较了 我们的方法 与 其他的 世界领先方法。我们选择了许多现存(exisiting)的经典模型,包括:深度卷积神经网络(DCNN)[2]、长短记忆单元的深度网络(LSTM-Net)[16]、文本-图像嵌入网络(TieNet)[18]、注意力引导课程学习(AGCL)[19]、类级残差注意力学习(CRAL)[51]、CheXNet[5]、病变位置注意力引导网络(LLAGNet)[6]和Yan等人的方法[52]。所有这些研究方法(除了LSTM-Net)都采用了官方数据集划分。对于CheXNet,我们展示了Yan等人实现的结果,该结果遵循相同的官方数据集划分。

??为了更公平的比较,我们遵循了[52],我们利用水平翻转、随机剪切来增强训练集,并使用了10个被裁剪子图像的平均概率(4个角剪切 和 1个中心剪切+其水平翻转版本)(four corner crops and one central crop plus horizontally flipper version of these)作为最终预测结果。如表4中展示的那样,Yan等人的方法是之前的世界最好水平AUC 0.8302,而我们的方法的标签 超过了 所有参与比较的模型 并取得了 新的世界最好水平AUC 0.8349。具体地,我们分类结果优于其他模型,14类中的9个。更详细地说,我们的方法优于其他模型,7个公共疾病(在NIH和CheXpert数据集中共享)中的6个,然而挖掘未标记的数据也有助于将性能提升到更高的水平,或仅在NIH中标记的类别上的类似性能(while mining the unlabeled data also helps boost the performance to superior or comparable performance on the classes labeled in NIH only)。总之,通过挖掘外部数据集的知识,我们的方法比之前最好的方法平均有0.47 AUC的提高。我们指出,在表III中的其他联合训练没有取得可以与 世界领先水平 比较的结果。因此,表IV中的比较是很有意义的。值得注意的是,我们设计了易于实现的损失(函数?)来从外部数据集中挖掘知识,而不是使用复杂的模型或者是组合多种模型。

IV-E. 在ImsightCXR数据集上的分类结果(Classification Results on ImsightCXR Dataset)

??为了证明我们方法的一般有效性(general effectiveness),我们在私有数据集ImsightCXR上开展了实验,其中NIH作为外部数据集。ImsightCXR数据集与NIH共享了12个病理学标签,然而ImsightCXR(it)包含了2个额外的标签:fracture和tuberculosis。因为没有其他研究可供比较,我们实现了3种方法:单一数据集模型(Single Dataset model),联合训练模型(Joint Training model),它(联合训练)是在IV-D1节中除了我们的方法外的最佳策略(best strategy),还有我们自己的方法。我们在表V中展示了定量(quantitative)分类结果。可以看到,加入外部域之后,在ImsightCXR数据集上的表现平均至少有1点的AUC提高(单一数据集0.884,联合训练0.894)。为了使得模型能够(encourage)缓和域变化(domain variance)并从未知标签中学习,我们的网络进一步取得了0.901 AUC比联合训练高0.7 AUC。具体地,我们的方法在14类中的10类中展现出了更好的结果,其他4类的结果与最好结果旗鼓相当。此外,公共标签上AUC的增加对整体性能的提高贡献更大,这表明公共类别的附加信息(additional information)更充分(sufficient)。

IV-F. 不同组件的分析(Analysis of Different Components)

??1)每种方法的对比实验(ablation study): 我们在表IV中展示了我们模型不同组件(each component)的效果。除了任务加权(task weighting,TW),具体任务对抗训练(task-specific adversarial training,TAT),时间整合(temporal ensembling,TE),不确定性机制(uncertainty mechanism)外,我们还和我们的变体(variants)进行了比较:把TAT换成整体对抗训练(holistic adversarial training,HAT),HAT以 N × C N \times C N×C??????的全连接层(FC-layer)结束,并根据单一的整体特征(single holistic feature)产生类分数(class scores);把UTE换成根据模型集合分配硬标签(Hard Label assignment by model ensemble)。表中的选中标记(checkmarks)表示包含了特定组件。我们计算了每种疾病的AUC,所有疾病的平均AUC(见表中的“Mean”项)。为了更好的观测特定设计在不同类别上的影响,我们也展示了仅在NIH数据集中被标记的7种疾病的平均AUC( M e a n C o m Mean_{Com} MeanCom?),以及 跨两个域共享的7种疾病的平均AUC( M e a n I n t Mean_{Int} MeanInt?)。

在ImsightCXR数据集上的分类结果,以NIH作为外部数据集。

我们方法的不同组件(之间)的对照实验。 M E A N C o m MEAN_{Com} MEANCom???:跨数据集共享的公共分类的平均AUC; M E A N I n t MEAN_{Int} MEANInt?仅在NIH数据集出现的分类的平均AUC。

??尽管添加了外部数据集之后,比如说CheXpert已经丰富了大量的NIH正样本,联合训练的AUC还是被限制在了0.8200。这表明来自外部域的知识可以被更有效的挖掘和利用。同时,采用TW策略之后能够有0.68的提升,这表明我们设计的加权任务公式(weighted task formulation)有利于解决这个问题(见实验b)。具体地,TW带来的提升主要来自 仅存在NIH数据集的类,在这些类中 M E A N C o m MEAN_{Com} MEANCom??增加了超过1个点。基于TW,加入TAT之后使得模型能够达到0.8306的平均AUC,在公共标签中平均有0.6的提升(见在实验c中的 M E A N I n t MEAN_{Int} MEANInt??)。进一步,我们发现直接使用 时间整合,不使用不确定性机制,会使得性能下降(从0.8320到0.8291;见实验g和d)。然而,使用不确定性感知的时间整合(UTE),不使用TAT,可以使得平均AUC提升到0.8302(见实验e)。特别地,TAT取得了第二高的 M E A N I n t MEAN_{Int} MEANInt??(0.8339),UTE取得了第二高的 M E A N C o m MEAN_{Com} MEANCom??(0.8285)。我们观察到,当将TW移除我们的模型之后,发生了严重的性能退化(AUC掉到0.8227,见实验f)。这个结果,加上实验b中的发现,表明,TW在我们提出的模型中起到一个极为关键的作用。尽管在实验c和e中展示出的性能已经可以与世界领先水平[52]一教高下,但是当把我们提出的所有组件组合在一起之后,还是能取得更好的性能表现(见实验g)。这表明,TAT与UTE在某个程度上是互补的。我们的模型平均AUC比简单联合训练(simple joint training)高1.2个点。此外,它(我们的模型)在所有实验中取得了最好的与 M E A N C o m MEAN_{Com} MEANCom??与 M E A N I n t MEAN_{Int} MEANInt??。这表明,我们提出的组件能够共同地提高模型(性能)。

??我们额外调查了TAT和UTE的效率,通过把其中一个替换成另一个(其他)组件。在实验h中,我们可以看到把TAT换成HAT,所有类的AUC显著的跌到了0.8234。和之前讨论的一样,单一整体特征向量(single holistic feature vector)携带了 太多(rich)的语义。因为(since)标签分布在CXR数据集中是多种多样的,鉴别器(discriminator)能够轻易地分辨出域的来源。因此,对抗训练可能会主导了分类任务并导致坏性能。我们在实验i中把UTE替换成硬伪标签(hard pseudo-label)的方法。作为结果,总体的性能减少了将近0.7个点(从0.8320到0.8251)。这(充分)展示了利用软标签作为未知标签目标的优势。

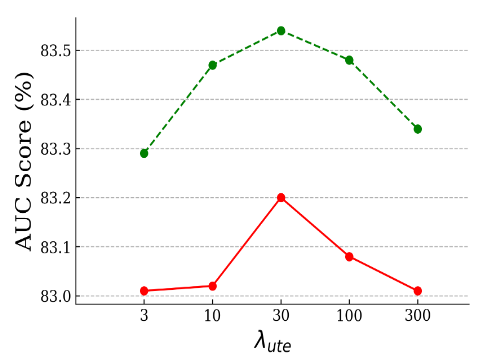

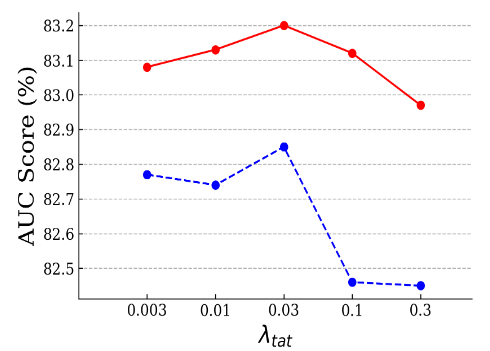

图4 在NIH数据集上超参数

λ

t

a

t

\lambda_{tat}

λtat?与

λ

u

t

e

\lambda_{ute}

λute?不同值的 疾病分类的平均AUC得分。红色曲线代表了全部14分类的平均AUC,蓝色曲线代表了公共标签的平均性能,绿色曲线代表仅在NIH出现的分类的平均得分。Best viewed in color。

(a) 当固定

λ

t

a

t

\lambda_{tat}

λtat?为0.03时,不同

λ

u

t

e

\lambda_{ute}

λute?在NIH数据集上AUC的变化。红色曲线:整体的平均AUC;绿色曲线:仅在NIH出现的分类的平均AUC。

(b) 当

λ

u

t

e

\lambda_{ute}

λute?固定为30时,不同

λ

t

a

t

\lambda_{tat}

λtat?在NIH数据集上AUC的变化。红色曲线:整体的平均AUC;蓝色曲线:公共分类的平均AUC。

??2)超参数实验: 我们进一步分析了,在NIH数据集上的实验中,超参数 λ t a t \lambda_{tat} λtat??与的 λ u t e \lambda_{ute} λute??影响。基于任务加权的模型,我们一开始将 λ t a t \lambda_{tat} λtat??固定为0.03,将 λ u t e \lambda_{ute} λute??从3变化到300,每个模型的系数约为3(with a factor of approximate 3 for each model?)。如图4(a)中所示,当把从 λ u t e \lambda_{ute} λute??3提高到30的时候,平均AUC与 M E A N I n t MEAN_{Int} MEANInt??都有一致地提升,当继续增加 λ u t e \lambda_{ute} λute??后,二者又一致的减小。我们还观察到,在所有设置为 λ u t e \lambda_{ute} λute??下(?),平均AUC大于0.8300。我们将固 λ u t e \lambda_{ute} λute??定为30,将 λ t a t \lambda_{tat} λtat??从0.003到0.3之间变化,每个模型的系数约为3(with a factor of approximate 3 for each model?)。如图4(a)中所示,当 λ t a t \lambda_{tat} λtat??从0到0.1之间变化时,模型的表现十分稳定。另外,当把 λ t a t \lambda_{tat} λtat??设为0.3时,我们可以看见公共类平均AUC的大跌。这表明,对抗损失主导了网络的训练(过程)。当 λ t a t \lambda_{tat} λtat??=0.03时,平均AUC与 M E A N C o m MEAN_{Com} MEANCom??达到了峰值。

V. 讨论(DISCUSSION)

??本次研究解决了联合训练在缺陷胸部射线图数据集(imperfect chest radiograph datasets)上的瓶颈。(瓶颈的)阻碍主要有两个方面:域差异和标签差异。在之前,许多的研究都集中在不同图像分布意义下的域偏移(domain shift)识别[13],[53]。然而,只有很少研究关注如何在联合训练中解决这个问题。同时,一些研究已经在多个CXR图像域上 进行了深度模型的训练。Yao等人[9]尝试建立一个二分类模型用于识别射线图片中,那些no finding的数据的,病理学特征。但是,在不同数据集中,对于“no finding”的定义是不一致的。这就可能是可见的提升受限的主要原因之一。Zhang等人[10]提出域泛化(domain generalization)方法,利用多个数据集中训练的效果来提高模型在未知数据集上的表现。他们的方法主要集中在学习更多的泛化特征,然而却忽略了标签差异。Lenga等人[11]认为连续学习的问题(continual learning problem)在于,当在新的域中学习的时候,模型需要“记住”之前学到的知识。他们对不同的策略开展了实验,并发现 相比于其他无遗忘学习(learning-without-forget)方法 联合训练取得了最好的AUC得分。然而,这些研究都没有解决联合训练的瓶颈问题。

??Guendel等人的目标与我们比较类似,他们把工作聚焦于 从PLCO数据集中挖掘位置知识(location knowledge)来提高NIH数据集的表现。他们认为可能是这样,数据集可能是基于不同标签定义建立的,并提出多任务网络 把 独立地处理来自不同数据集的标签。Cohen等人[53]指出,标签差异限制了深度模型的泛化表现。然而,我们在多任务设置上的实验表明,与在单个数据集上训练的模型相比,没有什么改进。这些研究表明,虽然某些程度的标签不一致性在数据集中存在,大部分的标签定义应该是相似的。因此,多任务模型不能够整合这些跨域知识。直到现在,最具鲁棒性地解决标签不一致性可能还是需要放射科专家(radiologists)的参与。比如说,人们可以用更加一致和严格的参考标准[54]来标记不同的数据集。当对数据集进行注释以训练更健壮的模型,有人还可以考虑利用观察者间的不确定性。如何利用深度学习方法来解决这个问题仍然是一个开放性问题。

在重新标记的NIH子集上的分类结果。

??除了我们发现的标签不一致性与标签差异,也有一些关于CXR标签噪声的讨论。公开的CXR数据集的注释常常是由自然语言处理根据放射学报告生成的,这就不可避免地产生了一定程度的噪音。一种常用的缓解标签噪声的方法是放射专家们手工标记图像(hand-label the images),就像我们ImsightCXR数据集那样。最近,Majkowska等人[54]重新标记了NIH测试数据集的一个子集(1,962张图片),每张图片至少通过3个放射专家(较准)。然后,我们进一步地在这些重新标记的数据集上进行测试,看是否我们的模型同样对这些噪声具有鲁棒性。为了与论文中使用的注释一致,我们平均了Edema,Consolidation,Mass,Nodule,Pneumonia,Atelectasis和Infiltration的输出,以作为“Airspace Opacity”的预测值。我们也平均了Mass和Nodule的输出,以作为“Mass or Nodule”的预测值。这些方法在表VII中展示出了一致性的提升。在TenCrop下,(我们)提出的方法进一步取得了竞争AUC,通过组合模型[54]在“Pneumothorax”上(0.925 v.s. 0.94)。注意到,这些对比的模型[54]都是在更小噪声,更大量的数据集上训练的,这些数据集放射专家们重新标记了37,521张放射图片。总之,这个实验展示出了我们方法对标签噪声的鲁棒性。

??我们当前研究的限制就是我们集中于采用大尺度的外部域来提高内部的某个性能。就上面提及的,在联合训练中外部数据集可以提高内部数据集的性能的一个原因是包含外部数据集之后,带来了大量的正样本。我们也尝试过合并两个数据集,比如说,CheXpert和MIMIC-CXR作为外部数据集,来提高NIH数据集。在NIH数据集上使用TenCrop的平均AUC为0.8353。这个结果表明,这一结果表明,当额外的样本没有带来更多倍的正样本时,可能存在一个为训练添加更多外部数据的饱和区域。此外,这可能是在三个或多个数据集上更具拓展性(scalable)的训练,并且可以建立一个 在各种数据集上都能够表现很好 的泛化模型(general model)。客观地来说,自动诊断辅助工具也需要覆盖更多的疾病,也是为了泛化的需要。一些研究开始研究这个复杂的场景,比如说普遍代表学习(universal representation learning)[32],[33]。我们以后的工作会参考这些研究,并发明更加复杂的神经网络,来实现一个(更加)通用的模型。此外,TW,TAT,UTE组件即插即用,并且可以单独地改进。将来的工作也会弄明白在目前的部分标签公式下,如何改良我们的方法。举个例子,任务的权重可以通过不同任务的梯度进行计算[39],TAT组件中的对抗训练可以使用更加先进性的GANs[56],UTE模块可以从统一其他半监督学习机制中获益[40],[57](?)。

??一般来说,如何建立一个自动胸部疾病检测系统,这个系统在多个域和越来越多的缺陷数据(imperfect data)中有泛化性,仍然是一个开放性问题。有许多其他研究课题集中于多个医疗数据集的训练,比如说 域泛化(domain generalization)[10],[58],增量学习(incremental learning)[11],普遍代表性学习(universal representation learning)[33]等。何如应对缺陷数据对所有(研究)来说,都是一个不可避免的问题。除了多点学习(learning with multi-site),还有许多CXR疾病识别的问题需要回答,比如说如何利用标签关系(label relations)而不是将多标签分类(multi-label classification)建模为独立的二元任务(binary tasks),如何解决大规模数据集被NLP工具标注时的噪声标注问题,如何处理 在标记数据时观察者之间和数据集之间的注释差异。如果我们可以从多个数据集中获得患者的人口统计学(demographic)(数据),那么这些因素(年龄,患者群体(patient cohort),扫描仪(scanner)等)也是值得研究的。我们将来的工作将会进一步深挖多个CXR数据集上的联合训练问题。

VI. 总结(CONCLUSION)

??在本文中,我们缓解(alleviate)了在缺陷数据集CXR数据集上的瓶颈,当包含外部数据集时。我们指出问题(瓶颈)有两个方面:域差异和标签差异。为了进一步应对这些挑战,我们将出现的部分标签分类问题转化为加权独立的二元任务。为了解决域差异(domain discrepancy),我们提出了特定任务对抗训练(task-specific adversarial training),用于针对更多公共分类的域不变(domain-invariant)特征的学习。为了解决标签差异(label discrepancy),我们提出不确定性感知的时间整合(uncertainty-aware temporal ensembling),逐渐地稳定地从未知分类中挖掘隐藏知识。据我们所知,这是第一项同时解决集成大规模医学图像数据集的域和标签差异的研究。我们在公开数据集和私有数据集上进行了广泛的实验,通过挖掘外部数据集的知识,我们的在NIH数据集上取得了世界领先水平的表现,这都展现了我们的方法的可行性(effectiveness)。我们的框架适用于训练多点(multiple sites)深度神经网络,并可以进一步扩展到实际临床用途。