1,动态规划

1.1,基本原理

动态规划是求解决策过最优化的数学方法,其基本思想是将待求解问题分解成若干个子问题,先求解子问题,然后从这些子问题的解得到原问题的解。适合于用动态规划求解的问题,经分解得到的子问题往往不是互相对立的,因次解决子问题的时候,其结果通常需要存储起来以解决后续复杂问题。这样就可以避免大量的重复计算,节省时间。

当问题具有以下特征时,可以考虑使用动态规划来求解:

- 一个复杂的最优解由数个小问题的最优解构成,可以通过寻找子问题的最优解来得到复杂问题的最优解。

- 子问题在复杂问题内重复出现,使得子问题的解可以被存储起来重复利用。

马尔可夫决策过程(MDP)具有上述两个特性。贝尔曼方程把问题问题递归为求解子问题,价值函数相当于存储了一些子问题的解,可以复用。因此可以使用动态规划来求解马尔可夫决策过程(MDP)。

使用动态规划算法求解马尔可夫决策过程(MDP)模型,也就是在清楚模型结构(包括状态转移率、回报率等)的基础上,用动态规划方法来进行策略评估和策略改进,最终获得最优策略。

- 策略评估(预测):给定一个马尔可夫决策过程模型MDP:

?和一个策略?

?,要求输出基于当前策略?

?的所有状态的值函数?

。

- 策略改进(控制):给定一个马尔可夫决策过程模型MDP:

?和一个策略?

?,要求确定最优值函数?

?和最优策略?

。

1.2,策略评估

策略评估要解决的问题是,给定一个策略?

,如何计算在该策略下的值函数?

。因为实际中涉及的马尔可夫模型规模一般比较大,直接求解效率低,因此可使用迭代法进行求解。考虑应用贝尔曼期望方程进行迭代:

状态?

?处的值函数?

,可以利用后继状态?

?的值函数?

?来表示,依次类推。

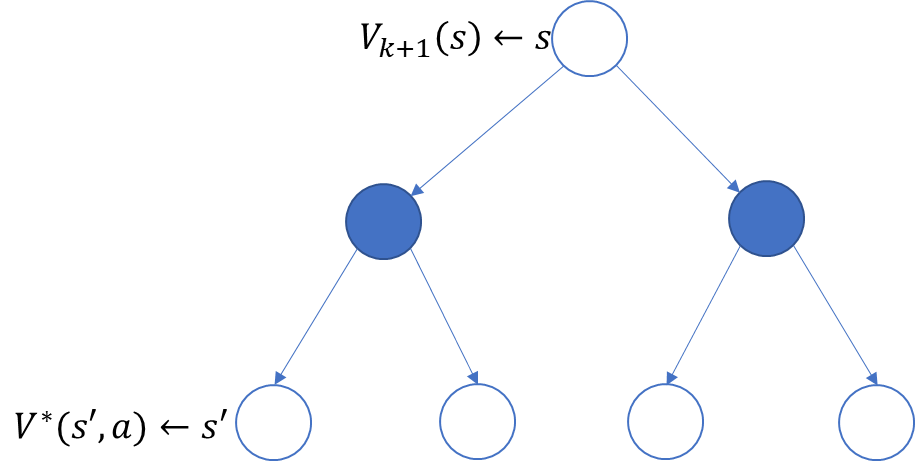

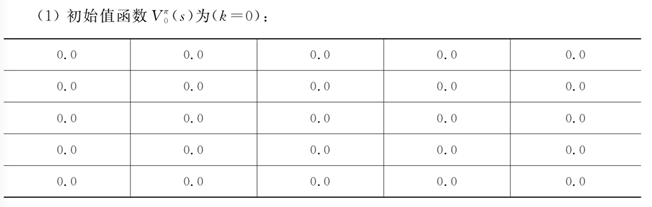

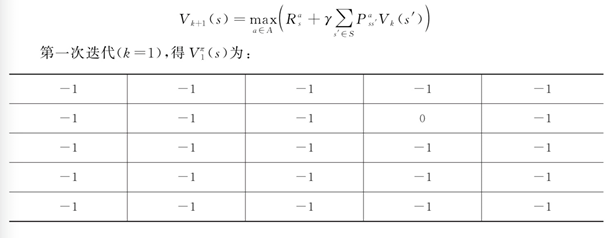

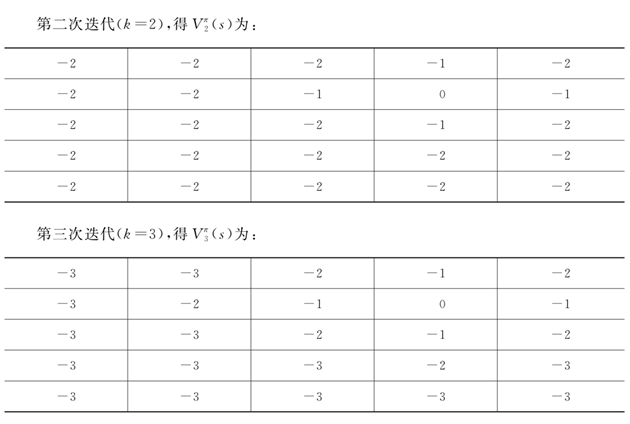

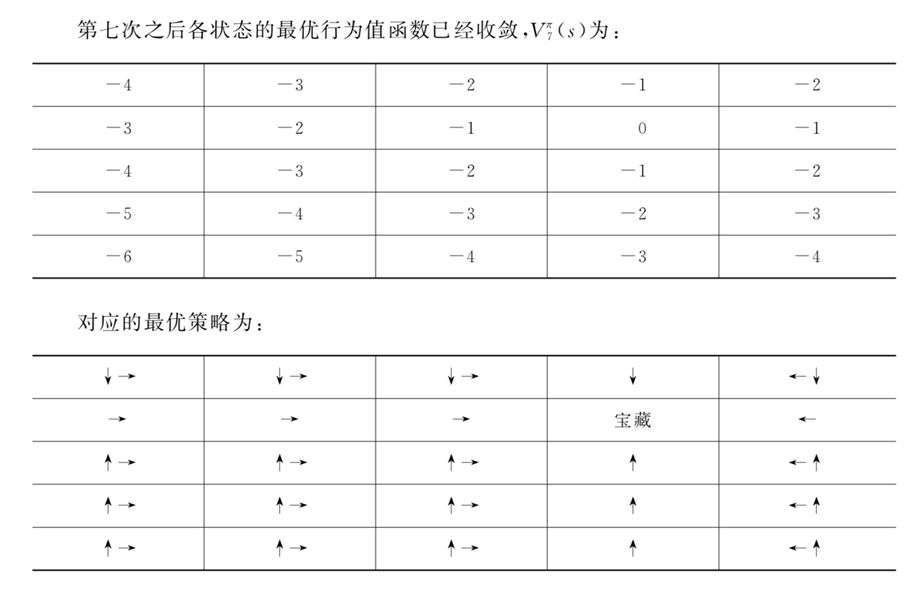

初始所有状态值函数(

)全部为:0 ,第 k+1 次迭代求解?

?时,使用第?

?次计算出来的值函数?

?更新计算?

?。迭代时使用公式如下:

对于模型已知的强化学习算法,概率和回报都是已知数,唯一的未知数是值函数,因此该方法通过反复迭代最终将收敛。

1.3,策略改进

计算值函数的目的是利用值函数找到最优策略。既然值函数已经获得,接下来要解决的问题是如何利用值函数进行策略改善,从而得到最优策略。

一个很自然的方法是针对每个状态采用贪心策略对当前策略进行改进,即:

其中,

在当前策略?

?的基础上,利用贪心算法选取行为,直接将所选择的动作改变为当前最优的动作。

令动作改变后对应的策略?

,

?为在状态?

?下遵循策略?

?选取的动作,同理?

?为在状态?

?下遵循策略?

?选取的动作。改变动作的条件是?

,则可得到:?

可见,值函数对于策略的每一点改进都是单调递增的,因此对于当前策略?

,可以放心地将其改进。

直到?

?与?

?一致,不再变化,收敛至最优策略。

贪心这个词在计算机领域是指在对问题求解时,总是做出在当前看来是最好的选择,不从整体最优上加以考虑,仅对短期行为(即一步搜索)求得局部最优解。将贪心算法应用在强化学习中求解最优策略函数实际上可以获得全局最优解,因为贪心策略公式中的值函数?

?已经考虑了未来的回报。因此在策略改进时,可以放心使用贪心算法求得全局最优解。

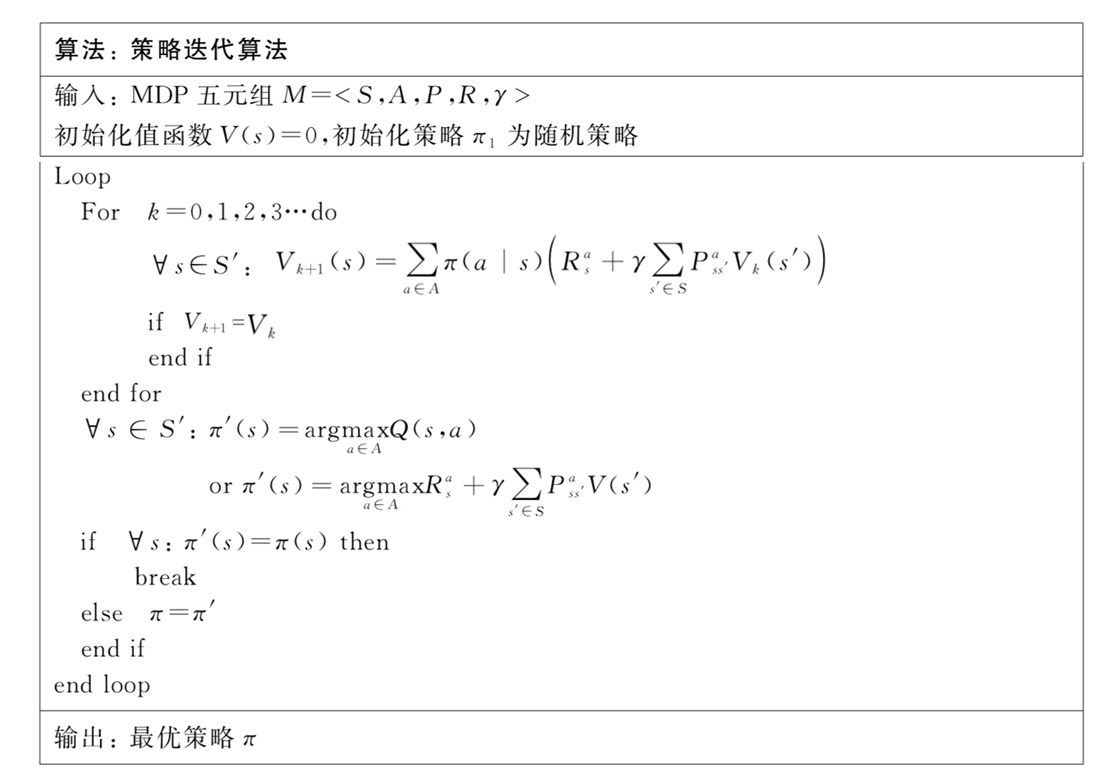

1.4,策略迭代

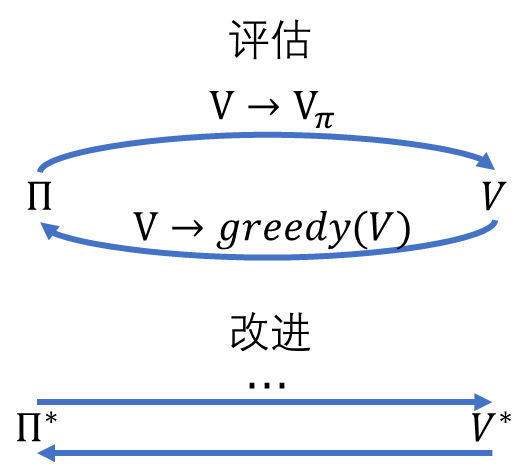

将策略评估算法和策略改进算法合起来便有了策略迭代算法。策略迭代算法通常由策略评估和策略改进两部分构成:

- 在策略评估中,根据当前策略计算值函数。

- 在策略改进中,通过贪心算法选择最大值函数对应的行为。

策略评估和策略改进两部分交替进行不断迭代。

假设我们有一个初始策略?

,策略迭代算法首先评估该策略的价值(用

?表示),得到该策略的价值函数?

?或?

?,下一步,策略迭代算法会借助贪心算法对初始策略?

?进行改进(用

?表示),得到?

。接着对改进后的策略?

?进行评估,在进一步改进当前策略,如此循环迭代,直到策略收敛至最优。

?

其中,

?为初始策略,

?表示策略评估,

?表示策略改进。策略评估过程中,对于任意的策略?

,通过贝尔曼方程进行迭代计算得到?

?。

策略改进部分,用贪心算法得到更新策略:

或

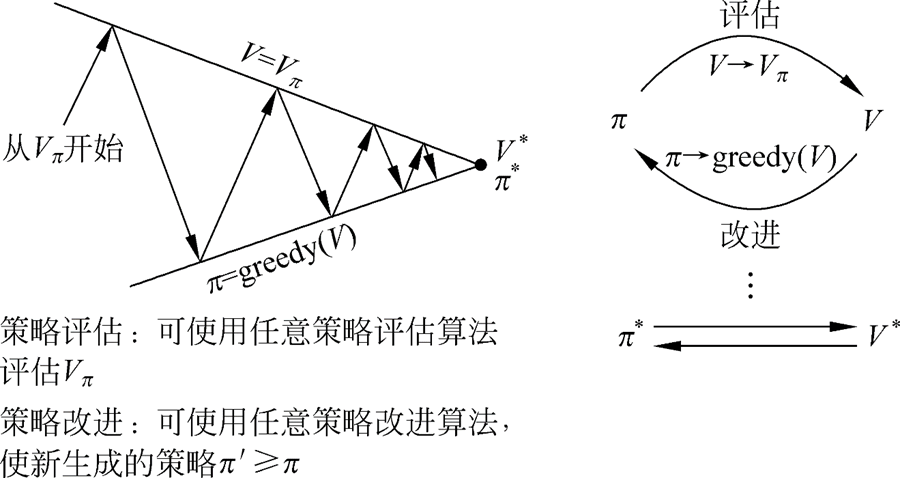

在策略评估过程中,往往需要等到值函数收敛之后才能进行策略改进,这其实是没有必要的。可以在进行一次策略评估之后就开始策略改进,如此循环往复执行这两个过程,最终会收敛到最优值函数和最优策略。

广义策略迭代(generalized policy iteration:GPI):

- GPI包含两个过程:策略评估和策略改进,两者可以以各种粒度交错进行。(如:值函数收敛之后进行策略改进,也可以进行一次策略评估之后就开始策略改进)

- 几乎所有强化学习方法都可以被描述为GPI,是一个普遍的方法。

- 评估、改进过程稳定,不再发生变化,则得到最优值函数和最优策略。

- 评估、改进过程可看作竞争与合作的过程,都把对方往相反地方拉,最终得到最优解。

- 直接朝着一个目标会导致远离另一个目标。联合过程更接近优化总目标。

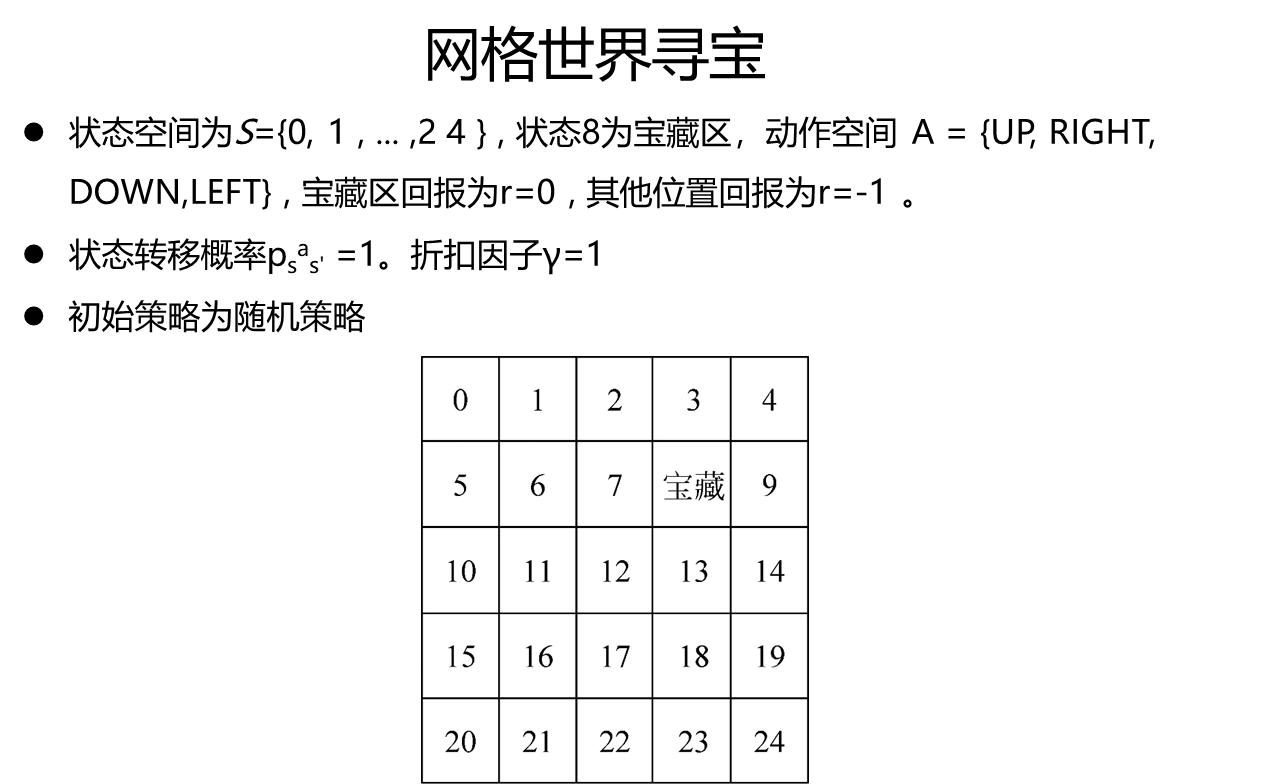

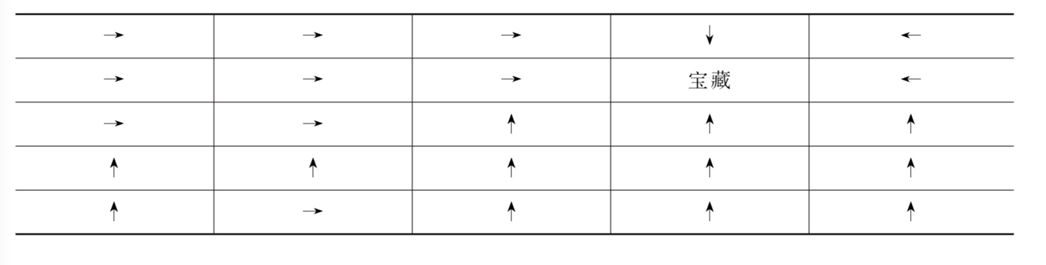

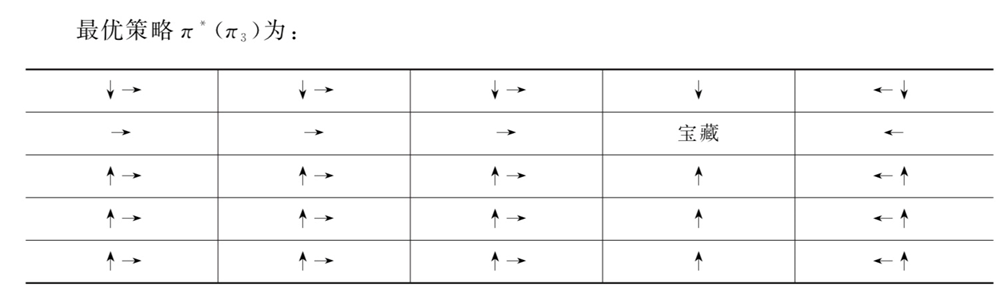

1.5,策略迭代(案例)

当智能体位于网格世界边缘时,任何使其离开网格世界的行为都会使其停留在当前位置。

使用策略迭代法对此问题求解,假设初始策略为均匀随机策略:

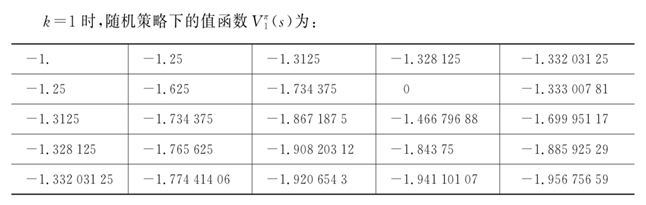

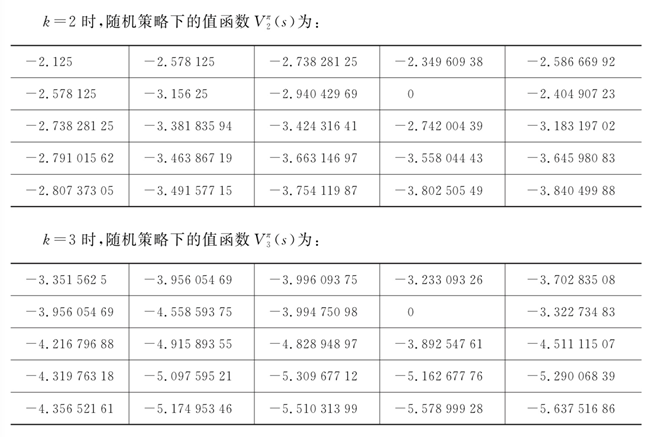

(1)首先评估给定随机策略下的值函数,使用贝尔曼期望方程迭代计算直至值函数收敛。初始化所有状态值函数为0,使用如下公式进行迭代值函数:

其中,

?表示当前状态的期望,而不是目标状态的期望。

?表示目标状态的状态值。

?

......

(2)使用如下公式:

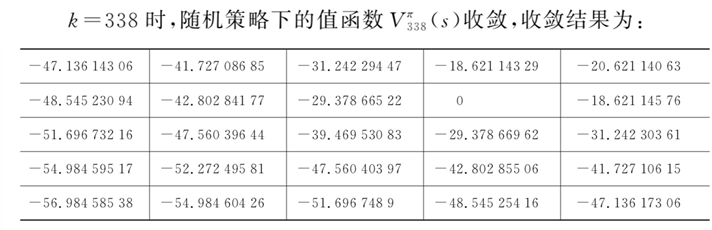

对收敛的值函数?

,使用贪心算法进行策略改进,求取?

?对应的改进后策略?

,则有

:

......

继续使用贝尔曼期望方程求取当前策略?

?下的值函数,直至值函数收敛,过程同(1):

针对值函数?

?进行第二次策略改善,得到?

继续求取?

?对应的值函数(策略评估),针对收敛的值函数??

?进行改进,得到?

经过三次策略改进,策略收敛。

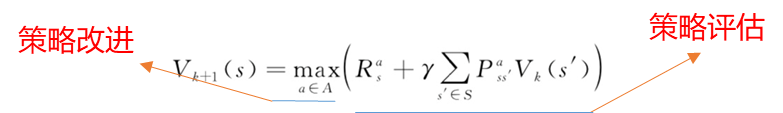

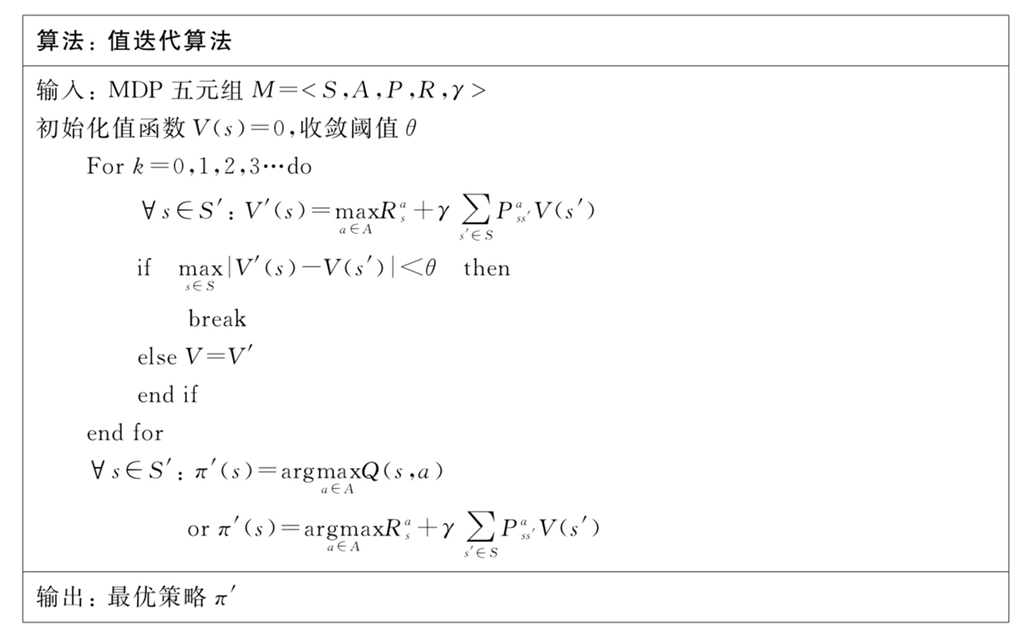

1.6,值迭代

策略迭代算法在每次进行策略评估时,采用贝尔曼期望方程更新值函数。而值迭代算法借助的是贝尔曼最优方程,直接使用行为回报的最大值更新原来的值。

值迭代算法将策略改进视为值函数的改善,每一步都求取最大的值函数,即:

假设在状态?

?下,有一个初始值函数?

,基于当前状态,有多个可选行为?

。每个行为?

会引发一个立即回报?

?,一个或多个状态转移,如从状态?

?转换至状态

?。不同状态?

?对应有不同的值函数?

?整个的?

?称为?

?的回报。值迭代直接使用所有行为引发的行为回报中取值最大的那个值来更新原来的值,得到?

?。如此迭代下去,直至值函数收敛,整个过程没有遵循任何策略。

虽然算法中没有给出明确的策略,但是根据公式:

可以看出策略迭代改进是隐含在值迭代过程中执行的。

1.7,值迭代(案例)

在进行一次策略评估(即求出当前策略下的值函数)之后就进行策略改进,这种方法被称为值函数迭代算法。即,在每次进行值函数计算时,直接选择那个是的值函数最大的行为。

2,蒙特卡罗

2.1,基本原理

动态规划是基于模型的强化学习方法,但在实际情况下,环境的状态转移概率及回报往往很难得知,此种情况下,动态规划就不再使用了。这时候可考虑采用无模型方法通过采样的方式替代策略评估,蒙特卡罗方法就是基于这个思想。

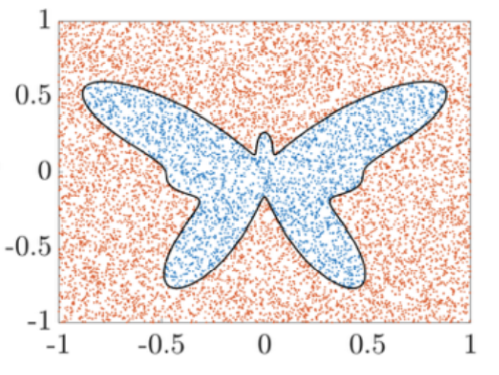

蒙特卡罗方法也称为统计模拟方法(或称统计实验法),是一种基于概率与统计的数值计算方法。该计算方法的主要核心是通过对建立的数学模型进行大量随机试验,利用概率论求得原始问题的近似解,与它对应的是确定性算法。

例如:计算图中蝴蝶的面积,可以通过随机撒豆子,统计在蝴蝶中豆子的比例进而计算蝴蝶的面积。

蒙特卡罗算法的核心思想是,在问题领域进行随机抽样,通过不断、反复、大量的抽样后,统计结果,得到解空间上关于问题领域的接近真实的分布。

蒙特卡罗强化学习在进行策略评估时,通过多次采样产生轨迹,求取平均累计回报作为期望累计回报的近似。整个蒙特卡罗强化学习使用了广义策略迭代框架,由策略评估和策略改进两部分组成,一次策略评估后面紧跟着对当前策略的改进,两个步骤交互进行,直至获得最优策略。

2.2,蒙特卡罗评估

蒙特卡罗评估是通过学习智能体与环境交互的完整轨迹来估计值函数的。所谓完整轨迹是指,从一个起始状态开始,使用某种策略一步步执行动作,直至结束形成的经验信息,包括所有时间步的状态、行为、立即回报等。

假设共执行?

?步,形成的完整轨迹如下:

使用蒙特卡罗方法评估策略时,对评估方法做了三点改变:

- 因为是无模型的方法,无法通过贝尔曼方程迭代获得值函数,因此通过统计多个轨迹中累计回报的平均数对值函数进行估计。

- 在求累计回报平均时采用增量更新的方式进行更新,避免了批量更新方法中对历史数据的存储,提高来计算效率。

- 为了方便直接从估计对象中求解最优策略,蒙特卡罗将估计值函数?

?改为估计行为值函数?

,这样可通过贪心策略直接获得最优行为。

利用平均累计回报估计值函数

值函数、行为值函数:

可见,状态值函数、行为值函数的计算实际上是计算累计回报的期望。在没有模型时,可以采用蒙特卡罗方法进行采样,产生经验信息。这些经验性信息经验性地推导出每个状态?

?的平均回报,以此来替代回报的期望,而后者就是状态值函数。状态值函数的估计通常需要掌握完整的估计才能准确计算得到。

当要评估智能体的当前策略?

?时,可以利用策略?

产生多个轨迹,每个轨迹都是从任意的初始状态开始直到终止状态,例如下面多个完整的轨迹:

- 轨迹1:

- 轨迹2:

- ......

计算一个轨迹中状态处?

?的基类回报返回值为:

为计算方便,轨迹中用累计回报代替立即回报,则上面的轨迹表达式可表示为:

- 轨迹1:

- 轨迹2:

- ......

在状态转移过程中,可能发生一个状态经过一定的转移后又一次或多次返回该状态,此时在多个轨迹里如何计算整个状态的平均回报呢?有两种方法:第一次访问蒙特卡罗方法(初访)和每次访问蒙特卡罗方法(每访)。

初访是指,在计算状态?

?处的值函数时,只利用每个轨迹中第一次访问到状态?

?时的累计回报。如轨迹1中,状态?

?出现了两次,但计算状态?

?处累计回报均值时只利用?

?初次出现的累计回报?

(不计算

?第二次出现后的累计回报

)。轨迹2中,状态?

?仅出现了一次,其累计回报为?

。因此初访法计算?

?的公式为:

其中,

?表示包含状态?

?的轨迹数。

每访法是指,在计算状态?

?处的值函数时,利用所有访问到状态?

?时的累计回报。如轨迹1,计算状态?

?处的均值时需要用到?

?。因此,每访法计算?

?的公式为:

其中,

?表示状态?

?出现的总次数。

蒙特卡罗方法是用统计的方法求取值函数的,根据大数定律:当样本数量足够多的时候,即?

?无穷大时,根据样本求取的值函数?

?接近于真实值函数

?。

增量式更新

通常,蒙特卡罗法再求平均值到时候采用批处理进行的,即在一个完整的采样轨迹完成后,对全部的累计回报进行更新。实际上,这个更新过程可以增量式进行,使得在计算平均值时不需要存储所有既往累计回报,而是每得到一个累计回报之后就计算其平均值。

对于状态?

,不妨设基于?

(初访法?

?指的是含有状态

?的轨迹书,每访法指的是状态

的数目)个采样数据估计出值函数为?

,增量公式:

则在得到第?

?个采样数据?

?状态对应累计回报时,有:

可简写为:

显然,只需要给?

?加上?

?即可,更一般地,将?

?替换为常数?

?, 令?

?,表示更新步长,

?越大,代表越靠后的累回报报越重要。

最终得到蒙特卡罗方法值函数估计的更新公式:

估计行为值函数?

?代替估计值函数?

动态规划中的策略迭代算法估计的是值函数?

,而最终的策略通过行为值函数?

?获得,或者下一个状态的?

?获得。当模型已知的时候,从值函数?

?到行为函数?

?有一个很简单的转换公式,可以根据此公式求解?

:

同时因为知道?

?和?

,也可以根据如下公式求解